지난달 서울 상암 디지털미디어시티(DMC)에서 개최된 ‘디지털 대한민국’ 행사에선 ‘시간을 뛰어넘은’ 음악 공연이 하나 열렸다. 가수 고(故) 김현식 목소리로 리메이크 신곡을 선보인 무대다. 1990년 세상을 떠난 김현식의 목소리로 1993년 가수 박진영이 발표한 ‘너의 뒤에서’가 흘러나왔다.

이를 가능케 한 기업은 인공지능(AI) 오디오 스타트업 수퍼톤이다. 이교구 서울대 융합과학기술대학원 교수 등이 2020년 3월 설립한 이 스타트업은 자체 목소리 합성 기술을 갖고 있다.

다른 AI 음성합성 스타트업과 다른 점은 평이한 일반 문장이 아니라 노래 등 감성 표현이 필수인 음성 콘텐츠까지 만들 수 있다는 점이다. 자체 개발한 가창 합성 기술(SVS), 음성합성기술(CVC), 실시간 음성 향상 기술(RTSE) 등이 대표적인 자체 기술이다.

수퍼톤은 AI에 음정·어조를 비롯한 ‘감성 정보’를 학습시킨다. 억양이나 음의 강약·길이·크기 등 내용과 상황에 따라 달라지는 음성 요소를 반영하기 위해서다. AI가 ‘미안해’ ‘고마워’ ‘저리 가’ 등을 각각 다른 어조로 맥락에 맞게 구현하도록 하는 식이다. 이같은 방식을 통하면 기존 자동안내서비스(ARS)의 ‘기계 말투’도 확 줄일 수 있다.

수퍼톤은 각종 음성 데이터를 대용량으로 사전 학습시켜둔 AI 모델을 쓴다. 적은 양의 새 음성 데이터만 확보해도 합성 음성을 만들어낼 수 있는 배경이다.

합성 음성을 만드는 과정은 대략 원본 데이터 확보, 데이터 가공, AI 학습·합성, 보정 등으로 나뉜다. 기존 원재료 음성을 확보하고, 여기에 잡음이나 음악이 섞여 있는 경우엔 음원 분리 기술로 목소리만 따낸다. 이 데이터는 고연산 컴퓨팅 서버를 통해 AI가 학습한다. 상용 콘텐츠의 경우엔 세밀한 연출을 위해 일부 후보정 작업이 들어간다.

1996년 세상을 뜬 가수 고(故) 김광석 씨의 목소리를 작년 초 재현했을 때도 이 같은 방식을 썼다. 약 1000곡 분량의 음원 파일을 학습한 기본(베이스) AI 모델에다 김광석 씨의 노래 9곡을 배우게 했다. 시간으로 치면 약 18분 분량 음성이다.

이 기술을 통하면 가상의 AI 가수·성우·연기자도 나올 수 있다. 한 사람이 대본을 죽 읽은 녹음본만 가지고도 마치 성우 10명이 나눠 읽은 것처럼 음성을 구현할 수 있어서다. 여러 사람이 따로 말한 것을 하나의 목소리로 합성해 내놓을 수 있다.

영화나 드라마의 경우엔 원작 배우의 목소리를 그대로 유지한 채 다국어 더빙을 할 수도 있다. 유명인이나 캐릭터 목소리를 기반으로 알람·안내 서비스도 가능하다. 콘텐츠 기업, 버추얼휴먼(가상인간) 운영 기업 등이 수퍼톤의 기술에 관심을 가지는 이유다. 작년 2월엔 엔터테인먼트 기업 하이브(옛 빅히트)가 수퍼톤에 40억원을 투자해 지분을 사들였다.

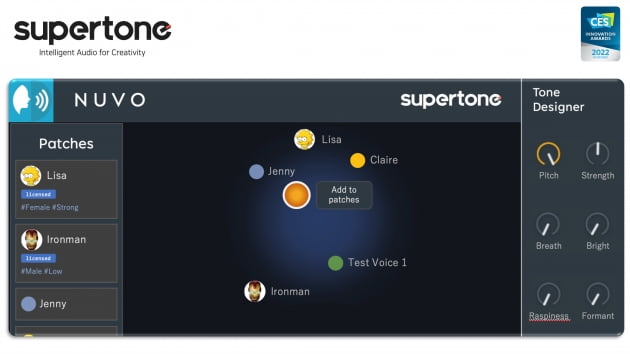

수퍼톤은 지난 7일 미국 라스베이거스에서 폐막한 세계 최대 IT·가전 전시회 CES 2022에서 자체 음성합성 솔루션 NUVO로 CES 2022 혁신상을 수상했다.

전시에선 참관객의 목소리를 유명 캐릭터 등 다른 목소리로 바꿔주는 기술을 선보였다. 단순히 빠르기를 다르게 한 음성변조가 아니라 AI가 목소리를 실시간으로 학습해 화자의 발음과 운율은 그대로, 목소리는 다르게 새 음성을 합성하는 기술이다.

수퍼톤 관계자는 “수퍼톤의 기술을 쓰면 음성에 감성을 더할 수 있어 더 몰입감 있는 콘텐츠를 제작할 수 있다"며 “전세계 콘텐츠 제작자들이 보다 혁신적인 제작환경을 누릴 수 있도록 기술을 고도화할 것”이라고 말했다.

선한결 IT과학부 기자

관련뉴스