이 기사는 국내 최대 해외 투자정보 플랫폼 한경 글로벌마켓에 게재된 기사입니다.

구글 인공지능(AI)가 아프리카와 남아시아 등을 포함해 전세계에서 사용되는 1000개의 언어를 지원하는 시스템을 구축한다. AI가 인공위성 사진을 분석해 산불의 예상 진로와 확산 경로를 파악하고 홍수를 예측해 주민들에게 경보를 제공한다. 또 음성을 이미지와 동영상으로 만들며, 음악 앞부분을 들려주면 뒷소절까지 자동으로 연주하는 것도 구글 AI가 진화하는 모습이다.

구글은 2일(현지시간) 미국 뉴욕 구글오피스에서 AI 연례 컨퍼런스 ‘AI@:불가능을 탐험하다’를 개최하고 이같은 내용의 진보된 AI 기능을 선보였다. 특히 인류의 문제를 해결하는 데 AI를 활용하는 데 초점이 맞춰졌다. 전설적인 프로그래머로 구글의 AI 연구를 총괄하고 있는 제프 딘 구글리서치 부사장 겸 구글시니어펠로는 "머신러닝 알고리즘 등 새로운 접근 방식은 AI가 수십억명의 사람들이 겪고 있는 실제 문제를 해결하는 데 도움이 됐다"며 "앞으로 더 많은 것을 선보일 것이며 이 AI 기술을 사용해 인류의 삶을 개선해나가기를 바란다"고 말했다.

○1000개 언어로 동영상까지 검색

구글은 전세계 1000개의 언어를 지원할 AI 모델을 구축하겠다는 '1000개 언어 이니셔티브'를 발표했다. 전세계에서 7000개 이상의 언어가 쓰이고 있지만 온라인에서 이용되는 언어는 몇 개에 불과하다. 구글은 온라인에서 텍스트를 학습하는 현재의 AI 모델로는 전세계의 다양한 의사소통을 학습하고, 정보에 접근하는 데 한계가 있다는 것을 인지했다. 이에 따라 세계에서 가장 많이 사용되는 1000개의 언어를 지원하는 AI 모델 구축해 수십억명의 사람들도 온라인에서 의사소통하고 정보를 수집할 수 있도록 하겠다는 게 구글의 구상이다. 구글은 이같은 작업이 수년의 시간이 걸릴 장기적인 프로젝트임을 명시했다. 이와 함께 1000개 언어를 지원하는 AI 모델은 텍스트 뿐만 아니라 동영상과 음성까지도 자동으로 번역하고 방식을 적용할 예정이다. 그 첫번째 단계로 구글은 400개 이상의 언어로 학습하는 유니버셜스피치모델(USM)을 개발했다. 이를 1000개로 확장하기 위해서 아프리카와 남아시아의 지방 정부, 연구단체 등과 협업해 다양한 언어와 그 방언의 오디오 샘플을 수집했다. 이렇게 학습시킨 AI 모델을 유튜브와 구글 번역 앱 등에 적용해 더 많은 사람들이 자신의 모국어로 기술을 활용하고 원하는 콘텐츠를 찾을 수 있도록 지원할 계획이다.

○홍수·산불 등 예보하는 AI

홍수나 산불로 인류에게 막대한 피해를 입히는 자연재해 문제를 해결하는 데도 AI 기술을 적용한다. 기후변화로 인해 더 자주 발생하는 이같은 자연재해를 AI 기술로 해결할 수 있다는 게 구글의 구상이다. 구글은 머신러닝으로 학습한 AI가 인공위성 촬영 이미지를 분석해 실시간으로 산불을 추적하는 시스템을 공개했다. 향후 산불이 어떻게 진행하고 있고 얼마나 확산될지를 예측하는 시스템이다.딘 부사장은 "AI 산불 추적 시스템을 호주, 미국, 캐나다, 멕시코에서 가동하고 있다"며 "지난 7월부터 미국과 캐나다에서 발생한 30건 이상의 대형 산불에 대한 정보를 구글 검색과 지도를 통해 사용자들과 소방팀에 알렸다"고 말했다. 이같은 정보를 통해 산불 인근 거주자들은 미리 대피할 수 있고, 소방팀은 산불 진압 계획을 세우고 진화에 직접적인 도움을 받을 수 있다.

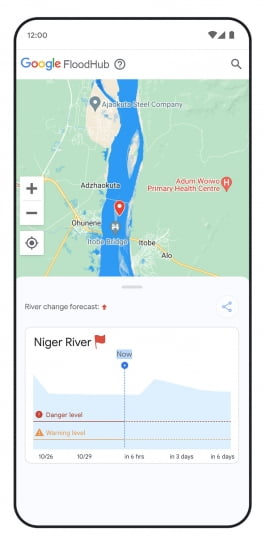

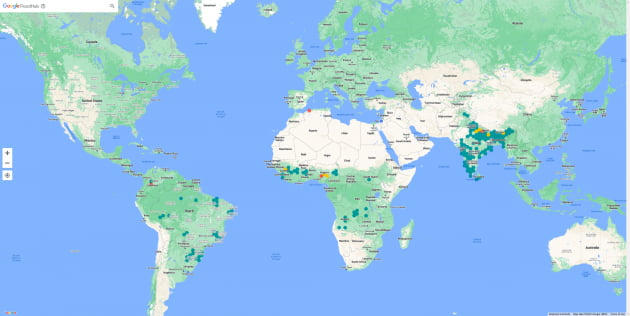

홍수 예측 시스템은 아프리카, 남미, 남아시아 등 홍수가 자주 발생하지만 조기경보시스템이 부족한 지역으로 확대됐다. 머신러닝을 통해 학습한 AI가 현재 기상상황과 강의 수위를 분석해 홍수 가능성을 예고해주는 시스템이다. 구글은 2017년부터 이 AI 기능을 운영해왔으며 신뢰할만한 정보로 개인들이 홍수에 미리 대응할 수 있도록 해왔다. 구글은 지난해 인도와 방글라데시에서 2300만명에게 1억1500만건의 홍수 정보를 알렸다. 구글은 "홍수 조기 경보 시스템을 통해서 사망 사고의 43%, 경제적 피해의 35~50%를 예방할 수 있다"고 했다.

구글은 올해 이런 홍수 예측 시스템을 강화하면서 브라질·콜롬비아·스리랑카·가나·나이지리아·라이베리아 등 18개 국가에도 적용한다고 밝혔다. 이와 함께 홍수 예측 플랫폼인 '플러드허브'를 전세계에 출시할 예정이다. 플러드허브의 홍수 예측 정보는 구글 검색과 구글 지도에도 적용해 보다 많은 사람들이 피해를 예방할 수 있도록 할 계획이다.

○동영상, 글, 음악도 창작

구글은 이날 사람이 문자로 명령을 입력하면 AI가 이미지, 동영상, 음악 등을 창작하는 '제너레이티브(생성) AI' 기술의 진화도 공개했다. 텍스트를 입력하면 영상을 만들어내는 ‘이매젠 비디오’와 ‘페나키’ 모델을 공개했다. 이매젠 비디오는 텍스트를 이미지와 짧은 동영상으로 바꿔서 생성하는 시스템이며, 페나키는 연속 학습 기술을 이용해 보다 긴 형태의 동영상을 만들어낸다. 이날 구글이 공개한 영상 가운데 하나는 파란색 풍선이 나뭇가지에 걸려 흔들리는 모습에서 동물원 속 기린이 나타났다. 구글의 AI 언어모델인 람다(LaMDA)를 활용해 글을 쓰는 프로젝트 '워드크래프트'도 선보였다. 람다는 사용자들이 어떤 주제로든 대화를 나눌 수 있도록 하는 엔진이다. 이를 활용해 짧은 문장을 입력하면 AI가 이후 문장을 쓰면서 글로 확장해내는 구조다. 현재 구글은 전문 작가들과 협업해 워드크래프트로 짧은 이야기를 작성해왔고 그 일부를 이날 공개했다.

또 6초 분량의 음성만 제공하면 이를 기반으로 사람의 목소리를 그대로 재현하고, 전주 몇 마디만 틀어주면 이후 연주를 이어가는 '오디오LM 기술'도 선보였다. 사람이 언어로 명령하면 AI가 스스로 코딩을 하는 기능도 공개했다.

실리콘밸리=서기열 특파원 philos@hankyung.com

관련뉴스