7일 관련 업계에 따르면 스위스 로잔 공과대학(EPFL) 연구진은 지난 3일(현지시간) 과학저널 네이처를 통해 쥐의 뇌 신호를 실시간으로 해석한 다음 쥐가 보고 있는 비디오를 재현할 수 있는 AI 도구를 개발했다고 밝혔다.

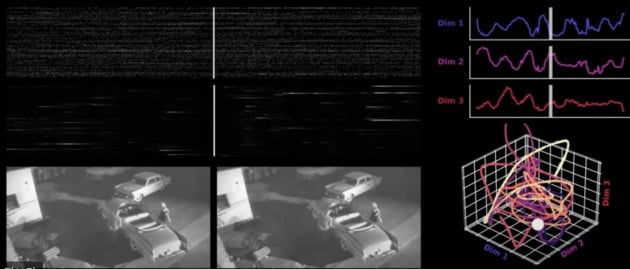

연구진은 50마리의 쥐에게 30초 분량의 비디오를 9번 시청하게 하고 뇌 활동 데이터를 수집했다. 영상은 1960년대 흑백영화로 한 남자가 차량의 트렁크에 무엇인가를 숨긴 뒤 달아나는 장면이었다.

연구진은 수집한 뇌 활동 데이터를 딥러닝 알고리즘인 ‘세브라(CEBRA)’라는 AI 모델에 학습시켜 뇌 신호를 비디오의 특정 프레임에 매핑했다. 그런 다음 새로운 쥐에 동일한 비디오를 시청하게 하면서 뇌 활동을 측정하고 이 뇌 활동 데이터를 세브라로 해석했다. 세브라는 쥐가 보고 있는 프레임을 실시간으로 예측할 수 있었고, 연구진은 예측한 프레임을 영상으로 변환했다. 그 결과 원본 영상과 거의 일치한 영상을 만들 수 있었다. 화면에 약간의 끊김과 어색한 움직임이 있었지만, 원본과 동일한 수준이었다.

연구팀은 “쥐가 돌아다니는 등 완전히 주의를 기울이지 않은 경우를 제외하면 원본 영상을 재구성할 수 있었다”며 “10년 전에는 뇌의 매우 단순한 신호만 해석할 수 있었지만 이젠 전체 영상을 변환할 수 있을 정도로 발전했다”고 설명했다.

이번 연구를 통해 사람의 기억이나 꿈을 영상으로 재현할 수 있게 된 건 아니다. 세브라가 사전에 해당 영상을 통해 훈련받았기 때문에 이 작업을 수행할 수 있었다. 하지만 연구진은 세브라가 신경학적 기능과 뇌가 자극을 해석하는 방법에 대한 통찰력을 제공할 것이라고 설명했다. 뇌 활동 패턴과 시각적 입력 사이의 연결을 밝혀냄으로써 이 도구가 시각 장애가 있는 이들에게 관련 감각을 생성하는 방법을 개발할 수 있을 것으로 기대했다. 또 치매 등 뇌 질환을 진단하고 치료하는 데 도움을 줄 수 있을 것으로 전망했다.

최진석 기자 iskra@hankyung.com

관련뉴스