2022년 말 챗GPT로 시작된 대규모언어모델 생성형 인공지능(AI) 열풍이 어느덧 일상에 자연스레 스며들었다. 열기가 잠시 사그라지는 듯하다가 또다시 다양한 형태의 새 프로그램이 출시되면서 더 나은 경험을 제공한 영향이다. 그리고 많은 이들이 AI 프로그램이 지닌 치명적인 문제인 ‘환각 현상(hallucination)’에 대해서도 잘 알고 있다.

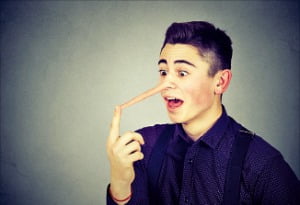

2022년 말 챗GPT로 시작된 대규모언어모델 생성형 인공지능(AI) 열풍이 어느덧 일상에 자연스레 스며들었다. 열기가 잠시 사그라지는 듯하다가 또다시 다양한 형태의 새 프로그램이 출시되면서 더 나은 경험을 제공한 영향이다. 그리고 많은 이들이 AI 프로그램이 지닌 치명적인 문제인 ‘환각 현상(hallucination)’에 대해서도 잘 알고 있다.환각 현상이란 AI가 정보를 처리하는 과정에서 발생하는 오류로, 거짓 정보를 묶거나 사실인 정보를 잘못 묶어서 거짓을 사실처럼 말하는 현상을 가리킨다. 때로는 존재하지 않았던 일을 마치 존재했던 일인 것처럼 알려주기도 하고, 상세하게 디테일까지 설명하기도 한다. 대규모언어모델이 방대한 데이터를 학습하는 과정에서 걸러지지 않은 ‘틀린 내용’을 토대로 나름의 체계적 답변을 구성하면 얼핏 맞는 말을 하는 것 같지만 사실은 얼토당토않은 내용이 답변으로 나올 수도 있다. 이런 현상은 비록 AI가 ‘엄청난 양’의 데이터를 학습했어도 데이터가 어느 순간 업데이트되지 않았기에 벌어지는 것으로 알려졌다.

이런 환각 현상은 AI 챗봇에서만 나타나는 오류일까? 그럴 리 없다. 굉장히 비슷한 일이 기업을 비롯한 조직의 리더에게 나타난다. 어차피 모든 AI는 인간의 뇌를 본떠 만들었지 않은가.

이런 환각 현상은 AI 챗봇에서만 나타나는 오류일까? 그럴 리 없다. 굉장히 비슷한 일이 기업을 비롯한 조직의 리더에게 나타난다. 어차피 모든 AI는 인간의 뇌를 본떠 만들었지 않은가.인간의 뇌는 어떤 기억이든 자기에게 유리한 방식으로 왜곡한다. 틀린 정보를 받아들인 뒤에도 여러 심리적 기제로 인해 이를 쉽게 수정하지 못하는 것은 인간의 본능이다. 여기에 ‘리더 자리에 올랐다’는 자만심과 자기만의 성공 공식까지 더해지면 리더가 각종 경영 문제에서 자기 확신에 찬 오답을 내놓으며 조직을 이끌 가능성이 높다. ‘조직이 문제없이 잘 돌아가고 있는데’라는 생각이 든다면, 그건 문제를 제대로 파악한 부하 및 동료 직원들이 일을 알아서 잘 수습해주고 있기 때문일지도 모른다.

이런 리더의 환각 현상을 방지할 방법은 무엇일까? AI 과학자들이 찾은 방식이 큰 도움이 될 것 같다. 바로 검색 증강 생성(RAG)이라는 것으로, AI 모델의 원래 학습에는 포함되지 않았던 소스를 이용하는 기술이다. 자체적인 재검색과 지식 재구성을 통해 정확한 답을 찾도록 도와주는 것이다.

리더에게 RAG는 무엇일까? 늘 외부를 만나 무언가를 묻거나, 새로운 지식을 담은 책과 영상을 찾아 공부하기에는 시간이 부족할 수밖에 없다. 그런데 당신에게 보고하러 오는 이들을 잘 보라. 외부에서 스카우트된 직원이든, 승진해 올라온 직원이든 그들은 특정 분야에 전문성이 있고 리더가 모르는 부분을 정확히 알고 있다. 조직의 RAG는 바로 내부 전문가 직원의 의견을 듣는 과정이다. 자연스레 리더의 환각 현상도 방지할 수 있을 것이다.

고승연 LG경영연구원 연구위원

관련뉴스