AI 알고리즘 연구 기업 하인텔은 AI 학습 시간과 전력 사용량을 줄이는 방법을 담은 논문을 사전 공개 사이트 아카이브(arxiv.org)에 발표했다고 12일 밝혔다. 생성 AI 핵심 기술인 ‘주의 기반 트랜스포머’를 양자역학적으로 재해석했다.

AI 알고리즘 연구 기업 하인텔은 AI 학습 시간과 전력 사용량을 줄이는 방법을 담은 논문을 사전 공개 사이트 아카이브(arxiv.org)에 발표했다고 12일 밝혔다. 생성 AI 핵심 기술인 ‘주의 기반 트랜스포머’를 양자역학적으로 재해석했다.트랜스포머는 문장 속 단어가 쓰인 맥락을 학습하는 신경망 기술이다. 오픈AI의 챗GPT, 네이버의 하이퍼클로바X 등이 이 기술로 작동한다. 획기적인 기술이지만 서버 사용량이 많고 학습 시간이 길다는 점이 한계로 꼽혔다.

하인텔은 복잡한 트랜스포머 동작을 물리학적 계산으로 환원했다. 생성 AI에 사용되는 트랜스포머는 입력된 사건(단어)으로부터 수백억 개 매개 변수로 이뤄진 계산 단계를 거쳐 다음에 일어날 사건을 예측한다. 하인텔 관계자는 “양자역학에서 미세 입자가 다른 상태로 넘어갈 때 예측에 사용되는 ‘파인먼 경로적분’ 단계와 트랜스포머 동작이 거의 같다는 점을 관찰했다”고 말했다. 긴 사건 정보를 소수의 상태 벡터로 압축할 수 있고, 많은 메모리를 쓰지 않고도 문맥 정보의 손실을 최소화할 수 있다는 설명이다.

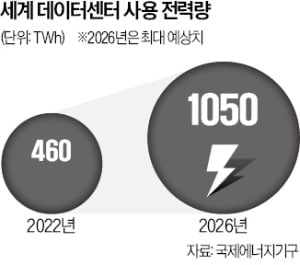

일정 수준 이상의 생성 AI를 만들려면 막대한 학습 시간과 전력이 필요하다. 자본력을 갖춘 기업이 아니면 개발에 나서기 어렵다. 글로벌 빅테크(대형 기술기업)들은 데이터센터 가동에 필요한 전력을 확보하는 데 몰두하고 있다. 이코노미스트에 따르면 알파벳(구글), 아마존, 마이크로소프트(MS) 등 클라우드 컴퓨팅기업은 지난 1분기 400억달러(약 55조원)를 투자했는데 이 중 대부분이 AI 구동을 위한 데이터센터 관련 투자였다. 국제에너지기구는 전 세계 데이터센터가 사용하는 전력량이 2022년 460TWh에서 2026년 1050TWh로 급증할 것이라고 내다봤다.

권대석 하인텔 대표는 “난해한 트랜스포머 동작 원리에 대해 새로운 접근 방법을 제시한 만큼 구글, 오픈AI 등 세계적 AI 기업과 비교해도 앞선 성과”라고 자평했다. 김동현 충북대 물리학과 교수는 “논문이 제안한 모델이 입증되면 파급력이 작지 않을 것”이라고 말했다.

고은이 기자 koko@hankyung.com

관련뉴스