IBM은 안전장치 AI 모델 ‘그래니트 가디언’을 22일 발표했다. 사용자의 명령어나 다른 생성형 AI의 답변에서 발생할 수 있는 위험 요소를 감지하는 데 특화한 모델이다. 사회적 편견, 증오, 유해성, 욕설, 폭력, 보안 우회 등 AI 활용 과정에서 나타나는 위험 요소를 사전에 탐지해 차단한다.

IBM은 안전장치 AI 모델 ‘그래니트 가디언’을 22일 발표했다. 사용자의 명령어나 다른 생성형 AI의 답변에서 발생할 수 있는 위험 요소를 감지하는 데 특화한 모델이다. 사회적 편견, 증오, 유해성, 욕설, 폭력, 보안 우회 등 AI 활용 과정에서 나타나는 위험 요소를 사전에 탐지해 차단한다.안전성 AI 모델은 다른 모델의 출력을 검토해 위험한 답변을 걸러내는 역할을 수행한다. AI 제품의 중심이 되는 파운데이션(기반) 모델은 성능 극대화에 집중하고 별개로 위험을 최소화하기 위한 안전 모델을 구축하는 식이다. 안전성 AI 모델은 서비스 개발·운영 과정에서 의도적으로 부적절한 명령어와 보안을 우회하는 프롬프트를 생성하는 용도로 쓰이기도 한다.

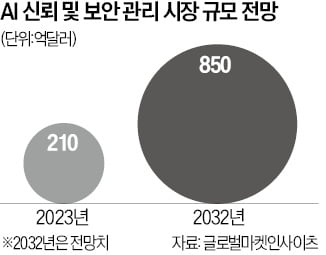

테크 기업들은 보안과 윤리에 중점을 둔 AI 모델을 연달아 내놓고 있다. 기업용 AI 시장에서 안전성이 핵심 경쟁력으로 떠오르고 있어서다. 메타는 지난해 AI 모델 출력을 모니터링하고 제어하는 ‘라마 가드’를 출시했다. 올해 4월과 7월엔 각각 ‘라마 가드2’와 ‘라마 가드3’를 발표해 성능을 고도화했다.

국내 AI 스타트업들도 AI 안전성 강화 제품 출시에 속도를 내고 있다. 튜닙은 6개의 보안 및 윤리 특화 모델을 통해 비윤리적 공격과 혐오 표현을 차단하는 솔루션을 제공한다. 콕스웨이브는 AI 모델의 취약성을 평가하고 잠재적 위협을 예방하는 ‘얼라인 AI’ 플랫폼을 운영 중이다.

황동진 기자 radhwang@hankyung.com

관련뉴스