17일 정보기술(IT)업계에 따르면 구글은 최근 ‘데이터 젬마’ 시스템에 RIG와 RAG를 결합해 LLM 성능을 향상하는 연구를 진행 중이다. 데이터 젬마는 경량화 LLM인 젬마와 대규모 공공 데이터베이스 데이터 커먼스를 결합해 정보의 정확성을 높이는 것을 목표로 한다.

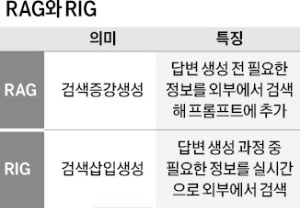

17일 정보기술(IT)업계에 따르면 구글은 최근 ‘데이터 젬마’ 시스템에 RIG와 RAG를 결합해 LLM 성능을 향상하는 연구를 진행 중이다. 데이터 젬마는 경량화 LLM인 젬마와 대규모 공공 데이터베이스 데이터 커먼스를 결합해 정보의 정확성을 높이는 것을 목표로 한다.여기에 적용된 RIG 기술은 답변을 생성하는 과정에 필요한 정보를 실시간으로 외부 데이터베이스에서 검색하는 방법이다. 모델이 답변을 만드는 도중에 스스로 자연어 질의를 생성해 외부 데이터베이스에 물어보고, 검색된 결과를 답변에 바로 삽입한다. 예를 들어 “2023년 서울의 평균 기온이 얼마인가”라고 질문하면 RIG는 답변 생성 과정에서 ‘서울의 2023년 기온 데이터’를 외부 데이터베이스에 물어보고 결과를 답변에 포함한다. 즉각적인 데이터 조회가 필요한 상황에 적합하다.

RAG는 RIG와 비슷하지만 순서가 약간 다르다. RAG는 답변 생성 전에 필요한 정보를 외부 데이터베이스에서 먼저 검색해 프롬프트에 추가한다. 가령 “미국과 중국의 이산화탄소 배출량을 비교해줘”라고 물어볼 때 RAG는 외부 데이터베이스에서 미국과 중국의 이산화탄소 배출량 데이터를 먼저 검색한다. 검색 결과를 프롬프트에 입력해 LLM이 더 정확한 답변을 만들도록 유도한다.

두 방식 모두 외부 데이터를 활용해 응답 정보의 정확성과 신뢰성을 높여준다. 하지만 방식의 특성에 따라 장단점이 존재한다. 실시간 정보를 반영하고 동적인 데이터 요청에 유연하게 대응해야 하는 경우엔 RIG가, 대규모 데이터 세트를 기반으로 정확하고 맥락에 맞는 답변을 생성해야 하는 경우엔 RAG가 더 알맞다.

이승우 기자 leeswoo@hankyung.com

관련뉴스