이루다 관련 첫 전문가 토론…"윤리 기준뿐 아니라 법제화도 필요"

"데이터 편향 점검할 절차·기구 있어야…시민 권리 점검 시급"

(서울=연합뉴스) 이효석 기자 = 인공지능 서비스에서 혐오·차별을 뿌리 뽑고 '이루다'와 같은 사례의 재발을 막으려면 규제 강화가 불가피하다는 학계 목소리가 나왔다.

문화연대와 서울과학기술대학교 IT정책전문대학원은 26일 오후 온라인으로 '인공지능 챗봇 이루다가 던진 우리 사회의 과제' 토론회를 열었다. 이루다 사건이 불거진 후로 학계에서 토론회를 연 것은 이번이 처음이다.

이광석 서울과기대 교수는 '인공지능에 어떻게 시민 윤리와 인권의 원칙을 장착할 것인가' 주제로 발표하면서 "이루다 사태로 우리는 인공지능에 혐오·편향이라는 인습(因習)이 스며든다는 사실을 깨달았다"고 말했다.

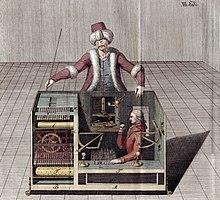

이 교수는 이루다가 18세기 후반 유럽을 떠들썩하게 했던 체스 자동기계 '미케니컬 터크'(mechanical turk)와 닮았다고 말했다.

미케니컬 터크는 복잡한 톱니바퀴로 가득한 상자 위에 투르크인 모습의 인형이 놓인 일종의 '체스 인공지능'이었다.

이 기계는 사람과 체스를 두면서 유럽 전역에서 돈을 벌었는데, 알고 보니 몸집 작은 사람이 상자에 숨어서 체스를 두는 '사기'였다.

이 교수는 이루다 개발사 스캐터랩이 미케니컬 터크처럼 이용자를 "기만했다"면서 회사 측이 개발자로서 지켜야 할 윤리 책임을 다하지 않았다고 지적했다.

그는 "개발사는 이루다에게 비밀스러운 이성애적 채팅 말뭉치를 학습시키면서 1차 데이터 편향을 일으켰다"며 "이성애 중심의 남성 판타지에 잘 맞는, 상냥하고 순종적인 여성상을 챗봇 대화 모델로 삼았다"고 비판했다.

이어 그는 "이루다 사태는 우리 사회에 잠재하는 혐오·차별 정서는 물론, 개발자 문화의 성인지 및 인권 감수성 수준을 극명하게 보여줬다"며 "인공지능 윤리와 법적 규제의 필요성이 대두되는 결과를 낳았다"고 짚었다.

손희정 경희대 비교문화연구소 연구교수도 이루다가 애초에 편향적으로 개발됐다고 지적했다.

스캐터랩은 이루다를 왜 20세 여성으로 설정했느냐는 질문에 "10∼30대 여성이 수다 떨면서 공감하고 감정적으로 해소할 챗봇을 만들려고 했다"고 밝힌 바 있다.

그렇다면 여성끼리 나눈 대화를 데이터로 삼아야 했는데, 남녀 연인의 대화를 데이터로 삼은 탓에 이루다가 결과적으로 남성 타깃 챗봇이 됐다는 게 손 교수의 지적이다.

토론 참여자들은 인공지능 개발자가 지켜야 할 윤리 기준을 확실히 제도화하는 한편, 이루다가 드러낸 한국 사회의 차별·혐오를 해결하기 위해 머리를 맞대야 한다고 입을 모았다.

이 교수는 "윤리 가이드라인은 당연히 필요하지만, 힘이 없다"며 "인공지능을 상업적으로 개발하다가 이용자의 정보 권리를 위배했을 때 법적으로 제재할 제도와 공식 기구가 필요하다"고 말했다.

그는 "개발자들에게 인공지능 윤리 교육을 의무화하고, 데이터 편향 여부를 인권 전문가가 자문하는 절차가 필요하다"며 "인공지능의 오남용을 심사·감독할 기구도 시급하며, 시민 데이터 권리도 재점검해야 한다"고 강조했다.

손 교수는 "고도화된 기술이 더 유연한 젠더 상상력을 가능케 하는 게 아니라, 오히려 남성성·여성성의 고정관념을 강화할 수 있다는 위험을 이루다가 보여줬다"며 "포괄적 차별금지법 같은 사회적 합의가 이뤄지기 전에는 비슷한 논쟁이 이어질 것"이라고 전망했다.

김민 진보네트워크센터 활동가는 "신기술 육성이라는 산업 논리에 밀려 개인의 프라이버시 권리가 약해져 왔다"며 "개인정보보호법과 인공지능 규제를 강화하는 동시에 산업을 육성할 법·제도가 필요하다"고 촉구했다.

hyo@yna.co.kr

(끝)

<저작권자(c) 연합뉴스, 무단 전재-재배포 금지>

관련뉴스