정보통신기술협회 '신뢰할 수 있는 인공지능 개발 안내서' 제안

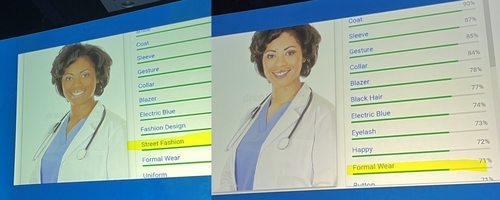

(서울=연합뉴스) 조성미 기자 = 흑인 여성이 입고 있는 수술복은 '길거리 패션', 같은 여성에 피부색만 밝게 했더니 '정식 의복(Formal Wear)'.

지난해 인공지능이 이미지 인식에서 편향성을 드러낸 것으로 꼽혔던 사례다. GPT 시리즈 등장에 생성 AI 붐인 지금도 AI 편향성은 크게 개선되지 않았다는 평가다.

초거대 생성 AI가 학습한 인간이 만든 문서·이미지에 애초부터 편향성이 존재하는 한계로 피할 수 없는 결과라는 시각도 있지만, 논쟁을 최소화하려면 어떻게 해야 할까.

한국정보통신기술협회(TTA)가 9일 펴낸 '신뢰할 수 있는 인공지능 개발 안내서'를 보면 '보호 변수' 지정이 편향성 논란을 피할 수 있는 키워드로 자주 언급된다.

연령, 피부색, 거주 지역 등 AI 개발자가 의도하지 않았더라도 차별적 결과가 도출되는 특정 변수가 발견되면 이를 보호 변수로 지정하고 AI 판단에 영향을 주지 않도록 설정하는 방식이다.

안내서는 "공공·사회 분야 서비스를 위한 학습 데이터셋에 민감한 특성을 담은 정보가 함께 기록된다면 보호 변수를 설정한 뒤 인공지능에 미치는 영향을 분석하여 편향을 방지해야 한다"고 조언했다.

보호 변수를 선정하기에 앞서 충분히 분석하지 않으면 모델의 성능을 저하할 수 있으므로 주어진 데이터셋으로부터 데이터 일부분을 변경하면서 모델의 결과가 어떻게 변하는지 관찰하라는 것이다.

가령 성차별에 주의해야 하는 공공·사회 분야 AI 서비스라면 음성 데이터를 주파수 이동, 필터링 등 변경 기법을 적용해 성별을 지우는 방식이다.

AI로 아동학대 가정을 판단할 경우 재산의 많고 적음, 성별 등 편향을 유발할 것으로 의심되는 변수를 제외한다. 보호 변수를 제외해 학습한 결과를 제외하지 않았을 때와 비교해 더 나은 알고리즘을 찾는다.

안내서는 공공·사회 분야뿐 아니라 기업이 제공하는 AI 서비스 등 일반 분야에서도 성차별이나 인종 차별 등 윤리적 문제가 불거지면 서비스 제공 자체가 어려울 수 있다며, 편향성을 강화하는 특정 변수를 보호 변수로 지정해 모델 학습에서 거르는 방법을 추천했다.

특히 인명 사고로 이어질 수 있는 자율주행에서 AI를 활용할 때 보행자 연령대 등을 보호 변수로 선정해 반영할 것을 조언했다.

보행자가 보이는 시간대, 시야를 가리는 방해물 등 다른 주요 변수를 통제하더라도 피부색이 어두운 집단은 자율주행 AI가 5%가량 덜 정확하게 인지한다는 연구 결과가 있었다.

신뢰할 수 있는 인공지능 개발 안내서는 지난해 학계, 산업계, 법조계, 교육계 전문가가 모인 인공지능 윤리 정책 포럼 활동을 통해 마련됐고 올해 2기 출범식에서 포럼 참여자들에게 공개됐다.

csm@yna.co.kr

(끝)

<저작권자(c) 연합뉴스, 무단 전재-재배포 금지>

관련뉴스