美 연구팀 "의료전문가, 질문 79%서 챗GPT 답변 선호…답변 질도 챗GPT가 높아"

(서울=연합뉴스) 이주영 기자 = 챗GPT 같은 생성형 인공지능(AI) 챗봇이 의학에서 어떻게 활용될지에 대한 관심이 커지는 가운데 챗GPT가 내과 환자의 질문에 대한 답변에서 품질과 공감도 모두 의사를 뛰어넘었다는 연구 결과가 나왔다.

미국 샌디에이고 캘리포니아대(UCSD) 퀄컴연구소 존 W. 에이어스 교수팀은 29일 동일한 내과 분야 질문에 대한 의사와 챗GPT의 답변을 의료전문가들이 평가하는 실험에서 답변의 질과 공감도 모두 챗GPT가 훨씬 우수한 것으로 평가됐다고 밝혔다.

이 연구 결과는 미국의학협회(JAMA) 학술지 'JAMA 내과학'(JAMA Internal Medicine)에 게재됐다.

연구팀은 미국 온라인 커뮤니티 레딧(Reddit)에서 의료 관련 질문 및 검증된 의료 전문가의 답변을 제공하는 플랫폼인 '애스크닥스'(AskDocs)에서 내과 분야 환자 질문과 검증된 의사의 답변 195개를 무작위로 선택하고 같은 질문에 대한 챗GPT 답변을 3명의 전문가에게 제공한 뒤 비교 평가하게 했다.

애스크닥스는 45만2천여 회원이 활동하는 사이버 공간으로 누구나 질문하고 답할 수 있지만 운영자는 전문가의 자격 증명을 확인해 답변에 이를 표시한다.

연구팀은 평가를 맡은 전문가 패널이 답변 출처가 의사인지 챗GPT인지 알 수 없도록 블라인드 처리했고 답변의 품질과 공감도를 평가하도록 했다.

연구팀은 챗GPT가 환자들이 의사에게 하는 질문에 정확하게 답할 수 있는지, 답할 수 있다면 AI를 의료시스템에 통합해 환자 질문에 대한 의사 답변을 개선하고 의사 업무 부담을 줄여줄 수 있을지 모색하는 게 이 연구의 목적이라고 말했다.

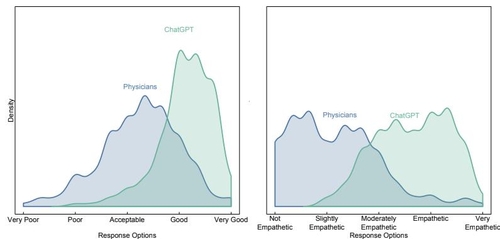

평가 결과 의료 전문가들은 전체 답변의 79%에서 의사 응답보다 챗GPT 응답을 선호하는 것으로 나타났으며, 품질도 챗GPT 응답이 훨씬 높은 것으로 평가했다.

응답의 품질에 대해 챗GPT 답변은 78.5%가 '좋음' 또는 '매우 좋음' 평가를 받았으나 의사 답변은 22.1%만 '좋음'과 '매우 좋음'으로 평가됐다.

또 답변에 대한 의료 전문가들의 공감 정도 평가에서는 챗GPT 응답의 45.1%가 '공감한다' 또는 '매우 공감한다'는 평가를 받았지만 의사의 답변은 4.6%만이 '공감' 또는 '매우 공감' 판정을 받았다.

논문 공동 저자인 애덤 폴리악 교수는 "이 연구는 챗GPT와 의사를 비교했지만, 궁극적인 해법은 의사를 완전히 쫓아내는 것은 아니다"라며 "대신 의사가 챗GPT를 활용하는 것이 더 나은 공감 치료를 위한 해답이 될 것"이라고 지적했다.

에이어스 교수는 "AI가 의사를 대체하지는 못하겠지만 챗GPT 같은 기술과 협력하면 의학에 혁명을 일으킬 수 있을 것"이라면서 "AI를 통해 의료 서비스를 개선할 기회는 엄청나며 AI 증강 치료가 의학의 미래가 될 것"이라고 말했다.

UCSD 의료부문 최고 책임자인 크리스토퍼 롱허스트 박사는 "이 결과는 AI 비서가 실제 의료서비스 제공 문제 해결에 어떻게 기여할 수 있을지 보여주는 첫 연구 사례"라며 "UCSD는 챗GPT 같은 도구가 환자 맞춤형 조언을 작성하고 이를 의료진이 검토하는 프로세스 마련에 착수했다"고 밝혔다.

scitech@yna.co.kr

(끝)

<저작권자(c) 연합뉴스, 무단 전재-재배포 금지>

관련뉴스